Eine Milliarde Milliarden Rechenoperationen pro Sekunde – die Supercomputer von morgen brauchen neue Software

28.10.2015

Eine Milliarde Milliarden Rechenoperationen pro Sekunde – die Supercomputer von morgen brauchen neue Software - Bildergalerie/Picture gallery

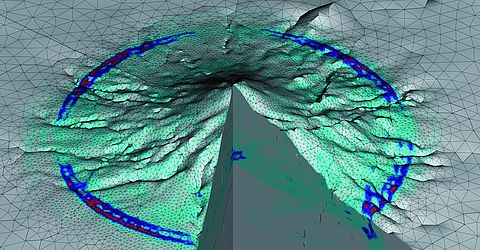

Simulierte Ausbreitung seismischer Wellen im Stratovulkan Mount Merapi

28.10.2015

Eine Milliarde Milliarden Rechenoperationen pro Sekunde – die Supercomputer von morgen brauchen neue Software - Bildergalerie/Picture gallery

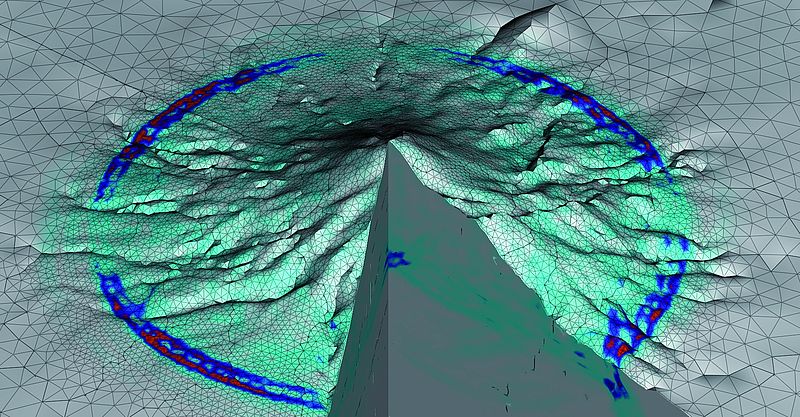

Bodenerschütterung aus einer Petascale-Simulation des Landers-Erdbebens 1992

28.10.2015

Eine Milliarde Milliarden Rechenoperationen pro Sekunde – die Supercomputer von morgen brauchen neue Software - Bildergalerie/Picture gallery

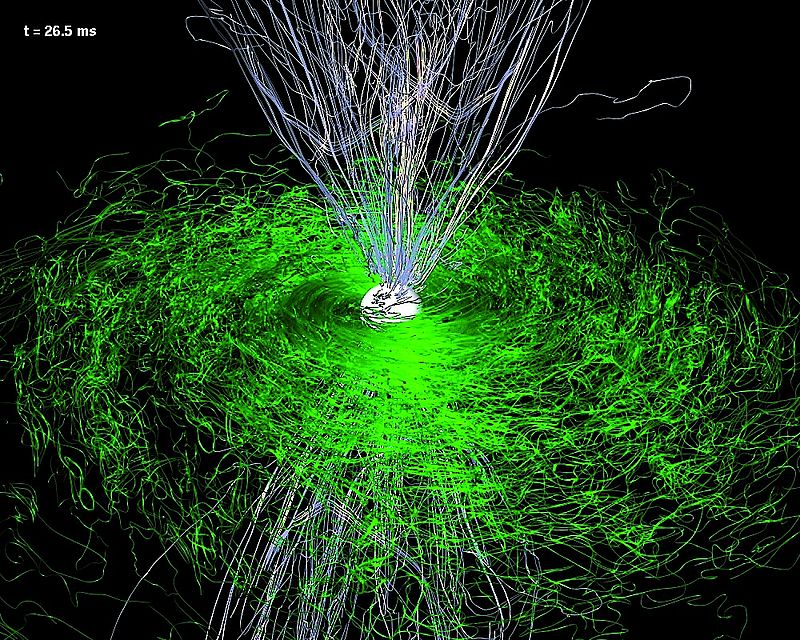

Magnetfeldlinien, nachdem der hypermassive Stern zu einem Schwarzen Loch kollabiert

28.10.2015

Eine Milliarde Milliarden Rechenoperationen pro Sekunde – die Supercomputer von morgen brauchen neue Software - Bildergalerie/Picture gallery

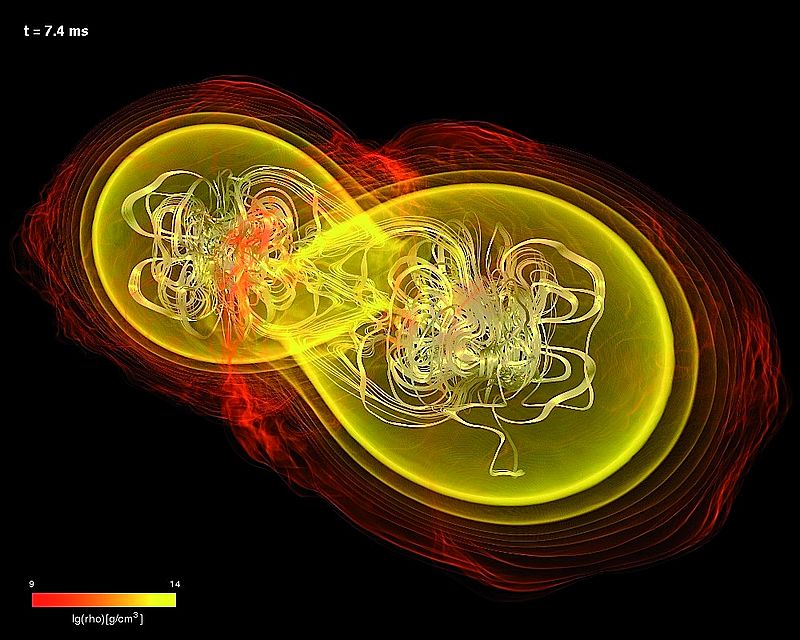

Verschmelzung zweier magnetisierter Neutronensterne

28.10.2015

Eine Milliarde Milliarden Rechenoperationen pro Sekunde – die Supercomputer von morgen brauchen neue Software - Bildergalerie/Picture gallery

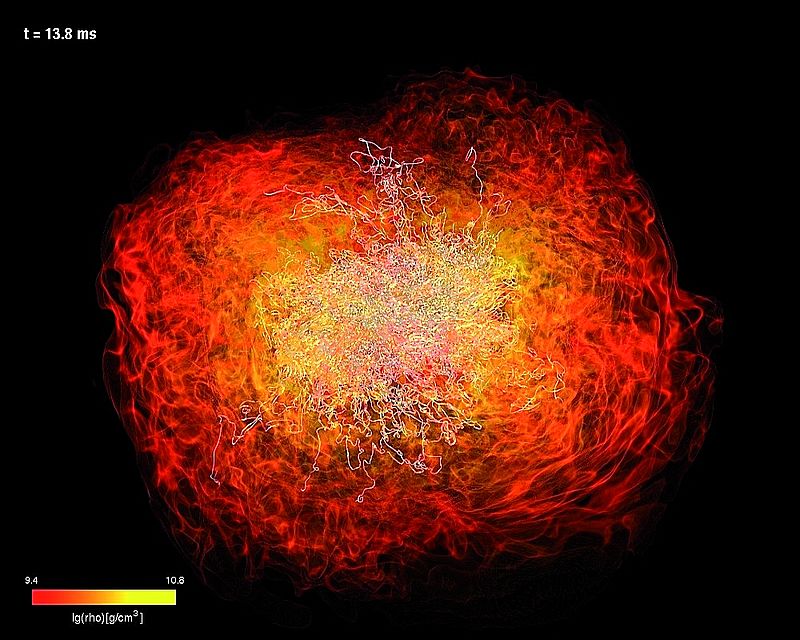

Hypermassiver Neutronenstern, der durch die Verschmelzung zweier magnetisierter Neutronensterne entstanden ist

28.10.2015

Eine Milliarde Milliarden Rechenoperationen pro Sekunde – die Supercomputer von morgen brauchen neue Software - Bildergalerie/Picture gallery

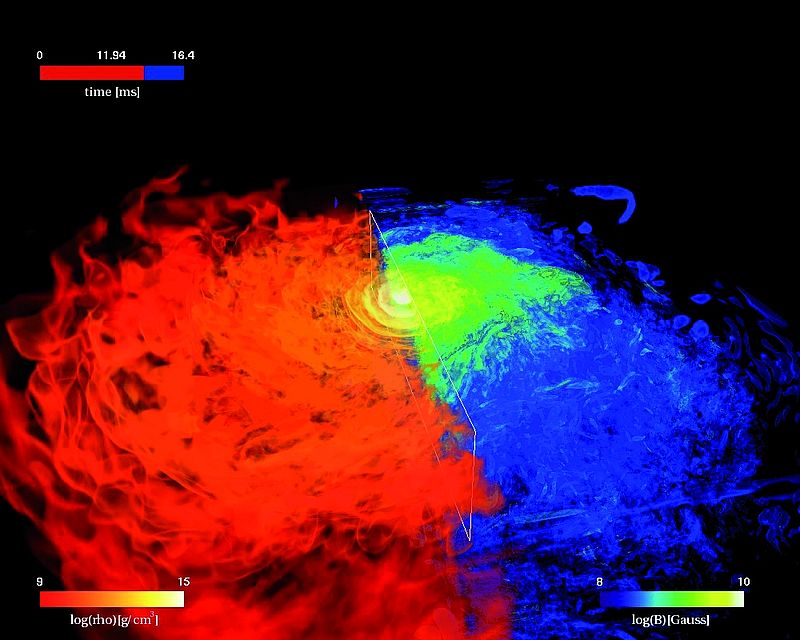

Dichte (rot) und Magnetfeldstärke (blau) eines hypermassiven Neutronensterns, der durch die Verschmelzung zweier magnetisierter Neutronensterne entstanden ist

28.10.2015

Eine Milliarde Milliarden Rechenoperationen pro Sekunde – die Supercomputer von morgen brauchen neue Software - Bildergalerie/Picture gallery

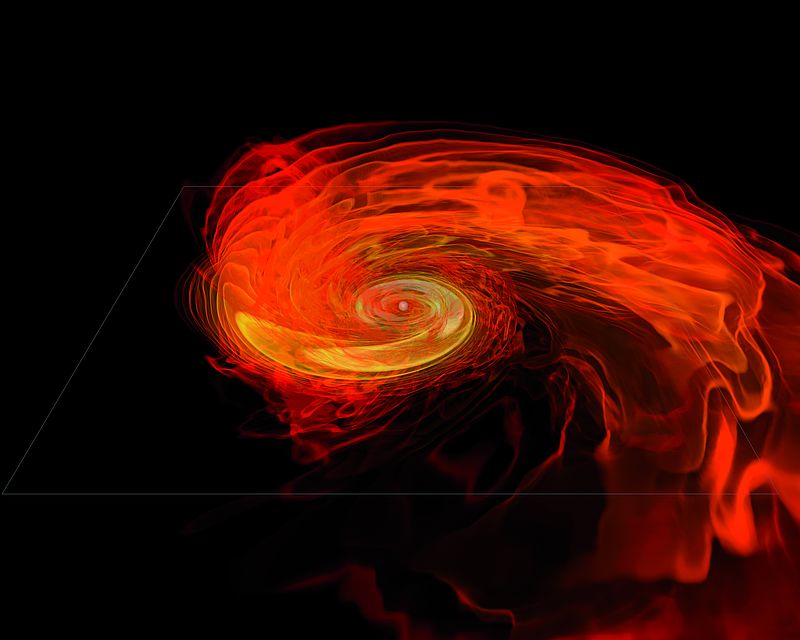

Torus-System eines schwarzen Lochs, das durch die Verschmelzung zweier Neutronensterne mit ungleicher Masse entstanden ist

28.10.2015

Eine Milliarde Milliarden Rechenoperationen pro Sekunde – die Supercomputer von morgen brauchen neue Software - Bildergalerie/Picture gallery

Logo ExaHyPE (4C)

28.10.2015

Eine Milliarde Milliarden Rechenoperationen pro Sekunde – die Supercomputer von morgen brauchen neue Software - Bildergalerie/Picture gallery

ExaHyPE-Koordinator Prof. Dr. Michael Bader

Institut für Informatik, Technische Universität München

München – Eine Milliarde Milliarden, also 1018 Rechenoperationen pro Sekunde (1 ExaFlop/s): Das ist die Leistung, die Supercomputer der nächsten Generation erbringen sollen. Dabei wird die Programmierung dieser Supercomputer selbst zur Herausforderung. Mit „ExaHyPE“ fördert die Europäische Kommission seit Oktober 2015 ein internationales, an der Technischen Universität München (TUM) koordiniertes Projekt, das in den kommenden vier Jahren die algorithmischen Grundlagen dafür legen soll. Ziel ist die Entwicklung einer neuartigen Software, zunächst für Simulationen in der Geo- und Astrophysik, die unter freier Lizenz veröffentlicht wird. Die Fördersumme beträgt 2,8 Millionen Euro.

Simulationsrechnungen treiben den wissenschaftlichen Fortschritt: Neben Theorie und Experiment sind sie das dritte Standbein des Erkenntnisgewinns. Supercomputer erlauben es, immer genauere und kompliziertere Modelle zu berechnen. Das EU-Projekt ExaHyPE („An Exascale Hyperbolic PDE Engine“), in dem sich ein interdisziplinäres Forscherteam aus sieben Institutionen in Deutschland, Italien, Großbritannien und Russland zusammengeschlossen hat, bindet sich in die europäische Strategie ein, bis 2020 einen Supercomputer im Exascale-Maßstab zu entwickeln. Um die gewaltige Rechenleistung auch für entsprechend umfangreiche Simulationsaufgaben nutzen zu können, muss die gesamte Supercomputing-Infrastruktur samt Systemsoftware auf diese ExaScale-Systeme vorbereitet werden.

Leistungsstark, flexibel und energieeffizient

Das Supercomputing der Zukunft stellt die ExaHyPE-Wissenschaftler vor gewaltige Herausforderungen. Das größte Hindernis für die Realisierung eines Exascale-Computers ist aktuell noch der Energieverbrauch: Die derzeit schnellsten Supercomputer der Welt – Tianhe-2 (China), Titan, Sequoia (beide USA) sowie der K Computer (Japan) – arbeiten im Petaflop/s-Bereich (1015 Rechenoperationen pro Sekunde) und benötigen zwischen 8 und 18 Megawatt (Quelle: www.top500.org), wobei die Energiekosten rund 1 Million US-Dollar pro Megawatt und Jahr betragen. „Ein Exascale-Computer, basierend auf aktuellen Technologien, würde mit einem Bedarf von knapp 70 Megawatt sowohl eine finanzielle wie auch eine infrastrukturelle Herausforderung darstellen“, erläutert ExaHyPE-Koordinator Professor Michael Bader von der TUM. „Die in ExaHyPE entwickelte Simulationssoftware wird daher konsequent auf die Anforderungen zukünftiger energieeffizienter Hardware ausgelegt.“

Auf Hardware-Seite ist daher mit einer extremen Parallelisierung zu rechnen. „2020 werden Supercomputer hunderte Millionen Rechenkerne umfassen“, so Bader. „Gleichzeitig wird die Hardware, die zur weiteren Leistungssteigerung an ihre physikalischen Grenzen getrieben wird und dabei zudem möglichst energieeffizient arbeiten muss, vermehrt zu Ausfällen neigen und somit schwankende Leistungskurven aufweisen. ExaHyPE untersucht daher die dynamische Verteilung von Rechenoperationen auf die Kerne, selbst wenn diese während der Rechnung ausfallen.“

Gleichzeitig gilt es, die hardwareinterne Kommunikation bei der Parallelisierung zu reduzieren. Zum einen geht jeder Datenaustausch zulasten des Energieverbrauchs. Zum anderen werden Supercomputer in zehn Jahren zwar 1000-mal so schnell rechnen können wie heute, doch die Zugriffszeit auf den Speicher wird sich nicht im gleichen Maße entwickeln. Um dennoch schnelle, energieeffiziente Rechenoperationen zu gewährleisten, sollen die verwendeten Algorithmen inhärent speichereffizient sein und so wenig Datenaustausch wie möglich erfordern.

Um möglichst geringen Speicherbedarf mit größtmöglichem Nutzen zu kombinieren, entwickelt das Konsortium neue skalierbare Algorithmen, welche die Auflösung von Simulationen, also die verwendeten numerischen Beobachtungspunkte, dort dynamisch erhöhen, wo die Simulationsrechnung dies erfordert – und nur dort. So können die Wissenschaftler die erforderlichen Rechenoperationen auf ein Minimum beschränken und gleichzeitig größtmögliche Genauigkeit in der Simulation erreichen.

Zwei Anwendungsszenarien: Erdbeben und Gammastrahlenexplosionen

Die ExaHyPE-Forscher werden die neuen Algorithmen anhand zweier Anwendungsszenarien aus der Geo- und Astrophysik erarbeiten: Erdbeben und Gammastrahlenexplosionen. Erdbeben lassen sich nicht vorhersagen, doch Simulationen auf Exascale-Supercomputern könnten es erlauben, zumindest die Risiken von Nachbeben besser einzuschätzen. Regionale Erdbebensimulationen versprechen vor allem ein besseres Verständnis der Vorgänge, die sich bei großen Erdbeben und deren Nachbeben abspielen. Im Bereich der Astrophysik soll ExaHyPE Systeme von umeinander rotierenden, sich vereinigenden Neutronensternen simulieren. Solche Systeme sind nicht nur die stärkste vermutete Quelle von Gravitationswellen, sondern könnten auch die Ursache von sogenannten Gammastrahlenexplosionen sein. Exascale-Simulationen sollen ermöglichen, diese seit langem bestehenden Rätsel der Astrophysik in neuem Licht zu studieren.

Trotz der beiden genau definierten Anwendungsgebiete wollen die Forscher die neuen Algorithmen so allgemein halten, dass sie – mit entsprechender Anpassung – auch in weiteren Disziplinen Anwendung finden, beispielsweise zur Simulation von Klima- und Wetterphänomenen oder von komplizierten Strömungs- und Verbrennungsprozessen in den Ingenieurwissenschaften, aber auch bei der Prognose von Naturkatastrophen wie Tsunamis oder Überschwemmungen. „Unser Ziel ist es, dass mittelgroße, interdisziplinäre Forscherteams die Simulationssoftware nach Fertigstellung binnen eines Jahres für ihre spezifischen Zwecke adaptieren können“, so Bader. Um eine rasche Verbreitung der neuen Technologie zu gewährleisten, wird das Konsortium sie unter freier Lizenz veröffentlichen.

Umfassende Expertise durch internationale, interdisziplinäre Kooperation

Die ExaHyPE-Projektziele erfordern eine intensive Zusammenarbeit von Experten über Disziplin- und Ländergrenzen hinweg. Auf deutscher Seite gehören dem Konsortium die Technische Universität München – Prof. Dr. Michael Bader (Institut für Informatik, High Performance Computing), das Frankfurt Institute for Advanced Studies – Prof. Dr. Luciano Rezzolla (Institut für Theoretische Physik, Goethe Universität Frankfurt), die Ludwig-Maximilians-Universität München – Dr. Alice-Agnes Gabriel und Prof. Dr. Heiner Igel (Department für Geo- und Umweltwissenschaften) sowie die Bayerische Forschungsallianz – Dipl.-Ing. Robert Iberl (Fachbereich Informations-/Kommunikationstechnologien) an. Italien ist mit der Università degli Studi di Trento – Prof. Dr. Michael Dumbser (Dipartimento di Ingegneria Civile Ambientale e Meccanica) beteiligt, Großbritannien mit der Durham University – Dr. Tobias Weinzierl (School of Engineering and Computing Sciences). Komplettiert wird das Konsortium durch den russischen Supercomputer-Hersteller ZAO "RSC Technologies" – Alexander Moskovsky (CEO).

Zur Bayerischen Forschungsallianz GmbH (BayFOR)

Die Bayerische Forschungsallianz hat das ExaHyPE-Konsortium bei der Antragstellung umfassend unterstützt und bei der Vertragsvorbereitung mit der EU-Kommission begleitet. Im laufenden Projekt übernimmt sie das Projektmanagement sowie die Verbreitung der wissenschaftlichen Ergebnisse. Die BayFOR berät und unterstützt bayerische Akteure aus Wissenschaft und Wirtschaft umfassend beim Einwerben von europäischen Mitteln für Forschung, Entwicklung und Innovation mit dem Ziel, den Wissenschafts- und Innovationsstandort Bayern im Forschungsraum Europa fortzuentwickeln. Der Schwerpunkt liegt dabei auf dem Rahmenprogramm für Forschung und Innovation, Horizon 2020. Als Partner im Enterprise Europe Network bietet sie zudem gezielte Beratung und Unterstützung für bayerische Unternehmen, insbesondere KMU, die sich für eine Teilnahme an EU-Forschungs- und Innovationsprojekten interessieren. Die BayFOR ist eine Partner-Organisation im bayerischen Haus der Forschung (www.hausderforschung.bayern.de) und wird vom Bayerischen Staatsministerium für Bildung und Kultus, Wissenschaft und Kunst gefördert. Weitere Informationen finden Sie unter www.bayfor.org.

Projekt-Website

www.exahype.eu

(Belegexemplar bei Verwendung erbeten: Bayerische Forschungsallianz, Prinzregentenstr. 52, 80538 München)

Kontakt in der BayFOR

Emmanuelle Rouard

Bereichsleiterin Presse- & Öffentlichkeitsarbeit

Tel.: +49 (0)89 9901888-111

E-Mail: rouard@no-spam-pleasebayfor.org